看到这么多漂亮的妹纸,内心是久久不能平静啊(滑稽脸 ̄ω ̄=)。这不,只能靠记录下怎么获取妹子们图片的流程来安稳心神了ヽ( ̄▽ ̄)ノ。

Model

创建了一个类,初始化:

读取网页源码:

这是将BeautifulSoup解析抽成一个方法,便于后面调用:

获取某一页面上的镁铝图片链接:

保存所有链接到列表:

最后便是保存图片,其中涉及到对标题需做一定的修改,确保文件夹创建成功:

All Images

|

|

Run

|

|

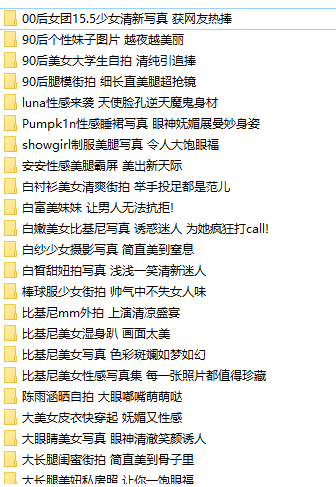

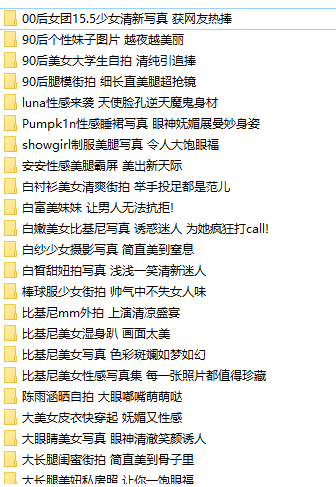

图片下载到本地后的结果:

看到这么多漂亮的妹纸,内心是久久不能平静啊(滑稽脸 ̄ω ̄=)。这不,只能靠记录下怎么获取妹子们图片的流程来安稳心神了ヽ( ̄▽ ̄)ノ。

创建了一个类,初始化:

读取网页源码:

这是将BeautifulSoup解析抽成一个方法,便于后面调用:

获取某一页面上的镁铝图片链接:

保存所有链接到列表:

最后便是保存图片,其中涉及到对标题需做一定的修改,确保文件夹创建成功:

|

|

|

|

图片下载到本地后的结果:

WeChat Pay

Alipay